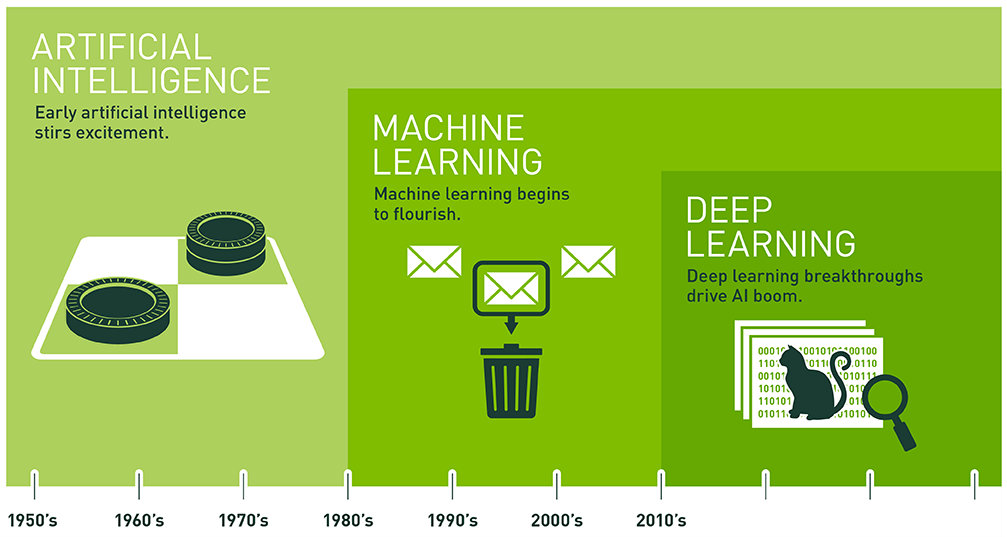

Bugünkü yazımızda, günümüzde etkin bir rol oynayan ve özellikle gelecekte çok büyük bir rol oynayacak yapay zekânın ne olduğunu, ne kadar geliştiğini ve yapay zekayı oluşturan makine öğrenmesi ve derin öğrenmenin neler olduğunu konuşacağız. Ardından makine öğreniminin ve derin öğrenmenin nerelerde kullanıldığına, Web 3.0(Semantic Web) ve yapay sinir ağı kavramlarının ne olduğuna değineceğiz. Verinin bu alanlarda ne kadar önemli olduğunu da açıklamaya çalışacağız.(DataSet, Data Science) IoT(Nesnelerin İnterneti), Prediction(Tahmin), Karar Ağacı, Bulanık Mantık, Gözetimli Öğrenme ve Pekiştirmeli Öğrenme gibi kavramları da inceleyeceğiz. Günümüzden yapay zeka örnekleri ile birlikte bu alanın nasıl geliştiğini de görmüş olacağız. İsterseniz ilk olarak yapay zekanın temellerinin nereye dayandığını incelemekle yazımıza başlayalım. * ile işaretlenen kavramlar yazı içerisinde açıklanacaktır.  Yapay zekanın temelleri 1830'lara uzanıyor diyebiliriz. Ada Lovelace ve Charles Babbage'in geliştirdiği matematiksel işlem gücüne sahip olan bilgisayar bir yapay zeka sayılıyor. Ardından 1940'larda ENIAC'ın geliştirilmesiyle birlikte bilgisayar biliminin gelişme süreci yavaş yavaş hız kazandı. Ancak yapay zeka çalışmalarının tam anlamıyla 1950'lerde başladığını söyleyebiliriz. 1950'li yılların başlarında Alan Mathison Turing, yaptığı çalışmalar sonucunda Turing testini geliştirdi. Turing testinin makinelerin ne derece düşünme yetisine sahip olduğunu değerlendiren bir kıstas olduğunu söyleyebiliriz. Günümüzden örnek verecek olursak şöyle açıklayabiliriz. Bir duvarın bir tarafına biz oturuyoruz, diğer tarafına ise bir makine ve bir insan yerleştiriyoruz. Hem insana hem makineye aynı soruları soruyoruz ve cevaplar alıyoruz. Sonrasında gelen cevaplara göre kimin insan kimin makine olduğunu anlayabilirsek makine Turing testinden geçememiş oluyor. Fakat makine, verdiği cevaplarla bizi insan olduğuna inandırabilirse testi geçmiş oluyor. Turing testi günümüzde geçilmiş bir test olduğu için geçerliliğini biraz olsa da yitirdi diyebiliriz. Ancak bu testin hâlâ öncü olarak kullanıldığını söyleyelim. Belki de işin korkutucu tarafı Turing testini geçmeyi başarabilecek bir makinenin isteyerek testi geçmemesi olabilir. Sadece bir örnek. Donald Hebb, 1949'da yayımladığı "The Organization of Behavior" adlı kitabında sinir ağlarında öğrenmenin nasıl olacağını dile açıklar. Yapay zeka terimi John McCarthy tarafından 1950'lerin ortalarına doğru ortaya atılmıştır. Harvard Üniversitesinden Marvin Minsky, IBM'den Nathaniel Rochester ve Claude Shannon gibi isimlerin de yer aldığı bir ekip, bu terim ve bu alan üzerinde araştırmalar yaptı ve sunumlar hazırladı. Yine bir sene sonra Allen Newell ve Herbert Simon tarafından Logic Theorist geliştirilmiştir. Bu program ilk yapay zeka programı olarak adlandırılmıştır. 1950'lerin sonlarına doğru ise John McCarthy, Lisp programlama dilini icat etmiştir. Lisp programlama dili yapay zekada kullanılan ilk dillerden kabul edilir. (Yapay zeka alanında günümüzde ağırlıklı olarak Python, R dili ve Java kullanılmaktadır.) Yine aynı dönemde Arthur Samuel, makine öğrenmesi kavramını ortaya atmış ve makinenin onu geliştiren kişiden daha iyi dama oynayabileceğini öğreneceğini söylemiştir.

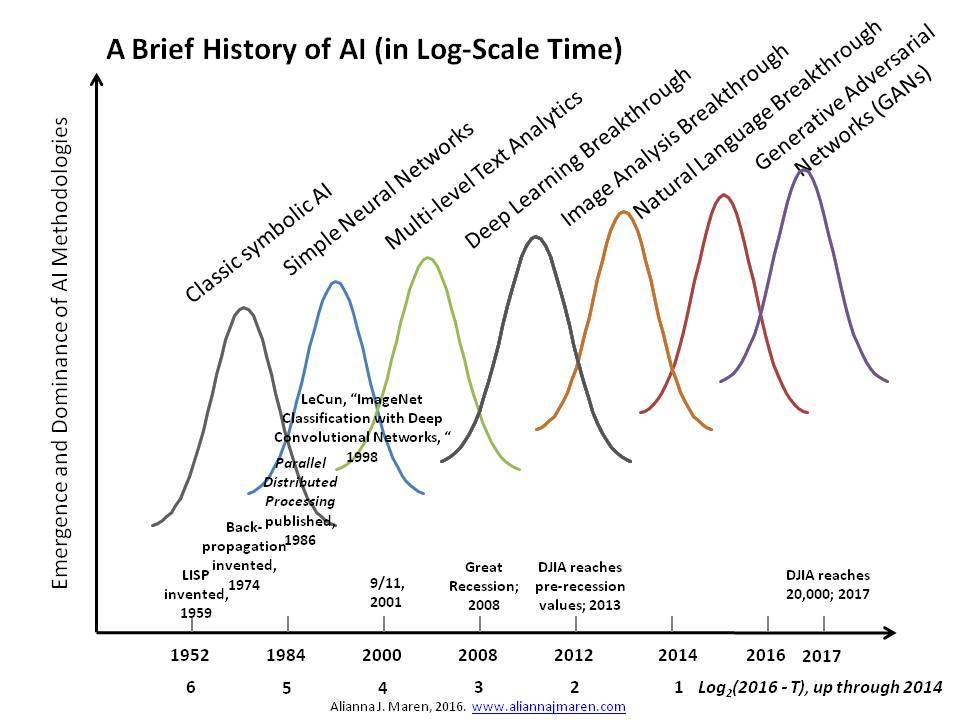

Yapay zekanın temelleri 1830'lara uzanıyor diyebiliriz. Ada Lovelace ve Charles Babbage'in geliştirdiği matematiksel işlem gücüne sahip olan bilgisayar bir yapay zeka sayılıyor. Ardından 1940'larda ENIAC'ın geliştirilmesiyle birlikte bilgisayar biliminin gelişme süreci yavaş yavaş hız kazandı. Ancak yapay zeka çalışmalarının tam anlamıyla 1950'lerde başladığını söyleyebiliriz. 1950'li yılların başlarında Alan Mathison Turing, yaptığı çalışmalar sonucunda Turing testini geliştirdi. Turing testinin makinelerin ne derece düşünme yetisine sahip olduğunu değerlendiren bir kıstas olduğunu söyleyebiliriz. Günümüzden örnek verecek olursak şöyle açıklayabiliriz. Bir duvarın bir tarafına biz oturuyoruz, diğer tarafına ise bir makine ve bir insan yerleştiriyoruz. Hem insana hem makineye aynı soruları soruyoruz ve cevaplar alıyoruz. Sonrasında gelen cevaplara göre kimin insan kimin makine olduğunu anlayabilirsek makine Turing testinden geçememiş oluyor. Fakat makine, verdiği cevaplarla bizi insan olduğuna inandırabilirse testi geçmiş oluyor. Turing testi günümüzde geçilmiş bir test olduğu için geçerliliğini biraz olsa da yitirdi diyebiliriz. Ancak bu testin hâlâ öncü olarak kullanıldığını söyleyelim. Belki de işin korkutucu tarafı Turing testini geçmeyi başarabilecek bir makinenin isteyerek testi geçmemesi olabilir. Sadece bir örnek. Donald Hebb, 1949'da yayımladığı "The Organization of Behavior" adlı kitabında sinir ağlarında öğrenmenin nasıl olacağını dile açıklar. Yapay zeka terimi John McCarthy tarafından 1950'lerin ortalarına doğru ortaya atılmıştır. Harvard Üniversitesinden Marvin Minsky, IBM'den Nathaniel Rochester ve Claude Shannon gibi isimlerin de yer aldığı bir ekip, bu terim ve bu alan üzerinde araştırmalar yaptı ve sunumlar hazırladı. Yine bir sene sonra Allen Newell ve Herbert Simon tarafından Logic Theorist geliştirilmiştir. Bu program ilk yapay zeka programı olarak adlandırılmıştır. 1950'lerin sonlarına doğru ise John McCarthy, Lisp programlama dilini icat etmiştir. Lisp programlama dili yapay zekada kullanılan ilk dillerden kabul edilir. (Yapay zeka alanında günümüzde ağırlıklı olarak Python, R dili ve Java kullanılmaktadır.) Yine aynı dönemde Arthur Samuel, makine öğrenmesi kavramını ortaya atmış ve makinenin onu geliştiren kişiden daha iyi dama oynayabileceğini öğreneceğini söylemiştir.

Yapay zekanın tarihçesinden biraz bahsettikten sonra makine öğrenmesi ve derin öğrenme kavramlarının neler olduğuna geçebiliriz. Makine öğrenmesi, derin öğrenmeden çok önce ortaya çıkan bir kavramdır. Önceki paragrafta belirttiğimiz üzere 1950'li yılların sonlarında ortaya çıkan bu kavram, verilen problemi daha önce elde edilen verilere göre şekillendiren bilgisayar algoritmalarının genel adıdır. Bize belirli bir veri yığını üzerinden bilgi veren genel algoritmalar oluşturma fikridir. Bu genel algoritmayı veri ile beslersek algoritma bu veri üzerinden kendi mantığını oluşturur. Tom Mitchell, makine öğrenmesini kitabında şu şekilde açıklıyor:

"Makine öğrenmesi alanı, deneyim kazandıkça kendi kendini geliştiren bilgisayar programlarının oluşturulmasını ele alır. Bir bilgisayar programı bazı görev (T) ve performans (P) ölçümlerinin yanı sıra deneyim(E) aracılığıyla da öğrenme yapabilir. Birçok alanda büyük miktarlarda veri üretilir ve bir istatistikçinin görevi bu verileri anlamlandırmak, önemli örüntü ve eğilimleri ortaya çıkarmak ve “verinin bize ne anlattığını” bulmaktır. Bu sürece veriden öğrenme adı verilir."

Buradan çıkartacağımız sonuç şu olabilir. Bir işi (T: Task) yaparken edinilen deneyim(E: Experience) arttıkça, işi yaparken ki performansı (P: Performance) artıyor.

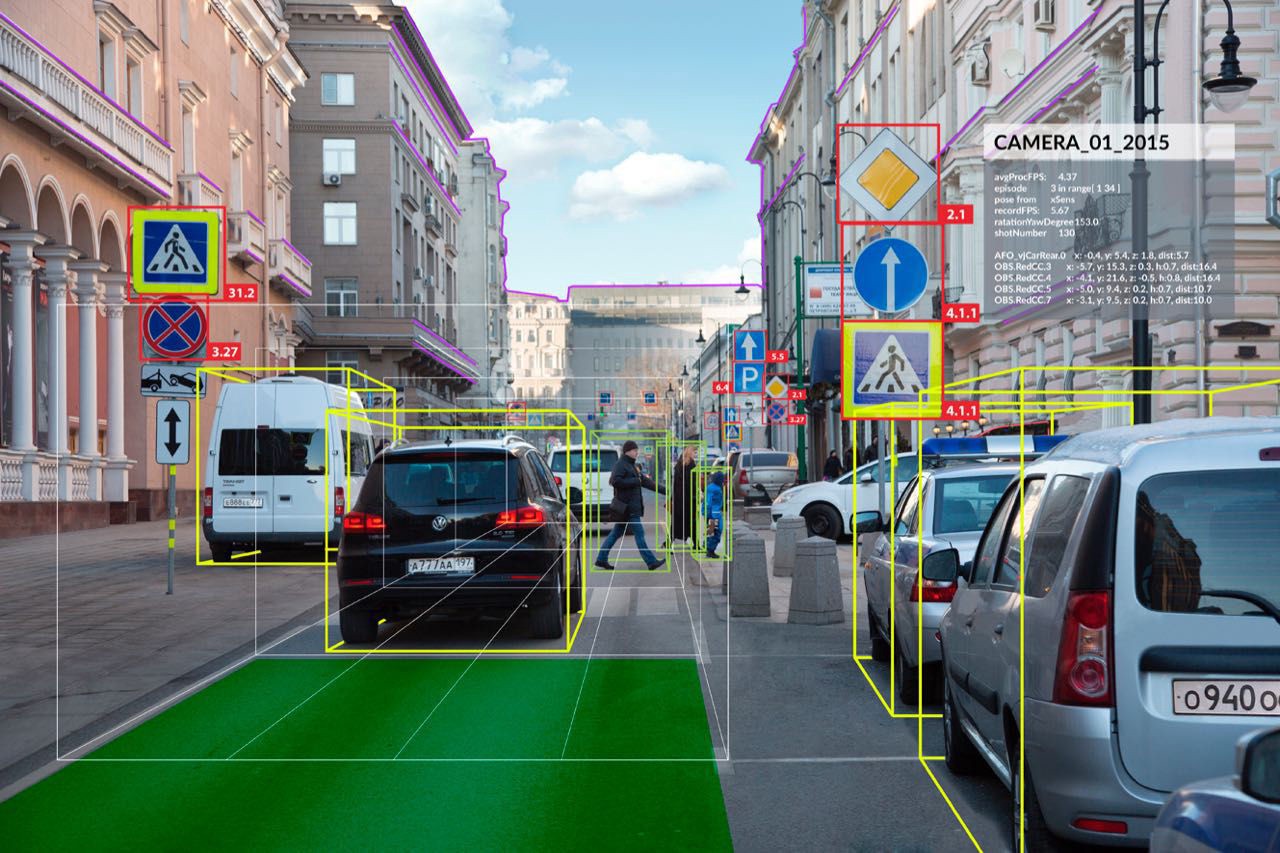

Konuyu biraz daha netleştirmeye çalışalım. Örneğin, kameraya gösterdiğimiz el yazısı ile yazılmış rakamların hangi rakam olduğunu söyleyebilen bir yazılım hayal edelim. Bu yazılıma bunu öğretmek için birçok veri ile beslememiz gerekiyor. Burada veri kümemiz birçok rakam örneği olacak. Makine bu veri kümesi(DataSet) üzerinden rakamları öğrenecek, deneyim kazanacak ve ardından kameraya bir rakam gösterdiğimizde bize doğru sonucu döndürecek. (Bu makine öğrenmesinin alt dalı olan derin öğrenmeye giriyor, bu kavramı biraz sonra netliğe kavuşturacağız.) Burada makine öğrenmesinin yanı sıra Computer Vision yani bilgisayarla görü ve Image Processing(Görüntü İşleme) de işin içine giriyor. Aslında görüntü işleme ve öğrenme, bilgisayarla görü alanının alt dalları denilebilir. Burada öğrenmenin alt başlık olması kafanızı karıştırmasın. Öğrenme birçok alanda kullanılan bir kavram. Görüntü işlemede de öğrenme çok aktif olarak kullanılıyor. Görüntü işleme bir resmi ya da videoyu analiz ederek karakteristik özelliklerini tespit etmeye yarar. Görüntü işleme, bilgisayarla görü ile karıştırılmamalıdır. Örneğin, bir yüz tanıma sisteminin yüzü algılaması ve okuması bilgisayarla görmedir. Daha sonra elde edilen görüntünün işlenmesi, düzeltilmesi ve iyileştirilmesi gibi işlemler görüntü işlemedir. İşte bu alanda makine öğrenmesi aktif olarak kullanılmakta. Görüntü işleme ile kanserli hücreyi saptamak buna örnek verilebilir. Bu kanserli hücreyi saptama işlemi ise makine öğrenmesi algoritmaları ile sağlanıyor. Bu alanın bu kadar gelişmesi ise hem işlenebilecek veri sayısındaki artış hem de kullanılan algoritmaların gelişmesinin doğal bir sonucudur. İşlenebilecek veri kümesi dediğimiz kavram aslında DataSet. DataSet makine öğrenmesi için gerekli olan örnek verileri içerir. Bu verilerle makinenin tecrübe edinmesi beklenir. Bilgisayar görüsünde çalışılan bir konuya örnek verelim. Mesela alışverişi merkezinde bulunan bir kamera alanı izliyor. Bir kapkaç olayı olduğunu düşünelim, hırsız çantayı çalıyor ve koşmaya başlıyor. Bu esnada beklenen şey kameranın alan taramasında insan hareketlerindeki tutarsızlıktan ve çantanın konumundan yola çıkarak bir alarm oluşturması. Bu da öğrenim ile gerçekleştirilebilecek başka bir örnek olabilir.

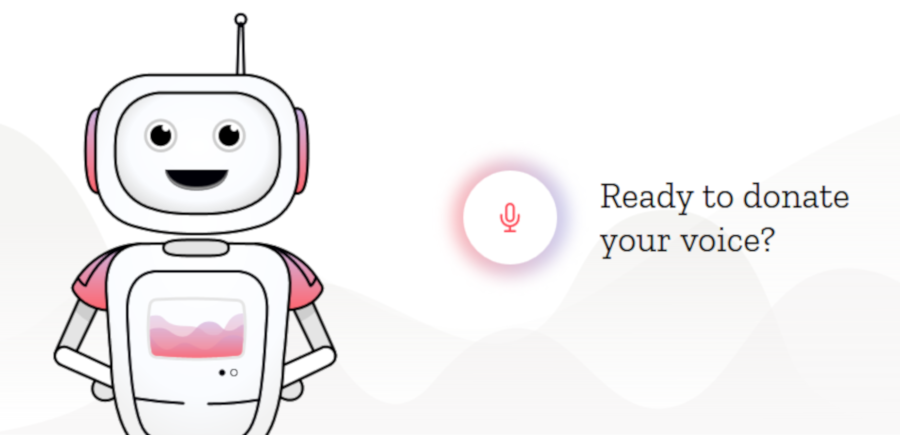

Konuyu biraz daha netleştirmeye çalışalım. Örneğin, kameraya gösterdiğimiz el yazısı ile yazılmış rakamların hangi rakam olduğunu söyleyebilen bir yazılım hayal edelim. Bu yazılıma bunu öğretmek için birçok veri ile beslememiz gerekiyor. Burada veri kümemiz birçok rakam örneği olacak. Makine bu veri kümesi(DataSet) üzerinden rakamları öğrenecek, deneyim kazanacak ve ardından kameraya bir rakam gösterdiğimizde bize doğru sonucu döndürecek. (Bu makine öğrenmesinin alt dalı olan derin öğrenmeye giriyor, bu kavramı biraz sonra netliğe kavuşturacağız.) Burada makine öğrenmesinin yanı sıra Computer Vision yani bilgisayarla görü ve Image Processing(Görüntü İşleme) de işin içine giriyor. Aslında görüntü işleme ve öğrenme, bilgisayarla görü alanının alt dalları denilebilir. Burada öğrenmenin alt başlık olması kafanızı karıştırmasın. Öğrenme birçok alanda kullanılan bir kavram. Görüntü işlemede de öğrenme çok aktif olarak kullanılıyor. Görüntü işleme bir resmi ya da videoyu analiz ederek karakteristik özelliklerini tespit etmeye yarar. Görüntü işleme, bilgisayarla görü ile karıştırılmamalıdır. Örneğin, bir yüz tanıma sisteminin yüzü algılaması ve okuması bilgisayarla görmedir. Daha sonra elde edilen görüntünün işlenmesi, düzeltilmesi ve iyileştirilmesi gibi işlemler görüntü işlemedir. İşte bu alanda makine öğrenmesi aktif olarak kullanılmakta. Görüntü işleme ile kanserli hücreyi saptamak buna örnek verilebilir. Bu kanserli hücreyi saptama işlemi ise makine öğrenmesi algoritmaları ile sağlanıyor. Bu alanın bu kadar gelişmesi ise hem işlenebilecek veri sayısındaki artış hem de kullanılan algoritmaların gelişmesinin doğal bir sonucudur. İşlenebilecek veri kümesi dediğimiz kavram aslında DataSet. DataSet makine öğrenmesi için gerekli olan örnek verileri içerir. Bu verilerle makinenin tecrübe edinmesi beklenir. Bilgisayar görüsünde çalışılan bir konuya örnek verelim. Mesela alışverişi merkezinde bulunan bir kamera alanı izliyor. Bir kapkaç olayı olduğunu düşünelim, hırsız çantayı çalıyor ve koşmaya başlıyor. Bu esnada beklenen şey kameranın alan taramasında insan hareketlerindeki tutarsızlıktan ve çantanın konumundan yola çıkarak bir alarm oluşturması. Bu da öğrenim ile gerçekleştirilebilecek başka bir örnek olabilir.  DataSet(Veri Kümeleri) hakkında günümüzden bir örnek vererek konunun anlaşılabilirliğini artıralım. Şu sıralar Mozilla'nın yürüttüğü Common Voice adında bir proje var. Bu projede amaçlanan şey makinelere gerçek insanların nasıl konuştuğunu öğretmek. Peki bu nasıl yapılacak? Bunun için devasa bir veri kümesine yani DataSet'e ihtiyacımız var. Bu veri kümesi farklı insan seslerini ve farklı kelimeleri kapsayacak. Bu devasa veri kümesini elde etmenin farklı yolları var ancak Mozilla bunu ucuza getirmek için bu proje kapsamında dünyadaki tüm insanlardan ses örneği alıyor. Aslında ucuza getirmenin yanı sıra bunu açık halde sunmak istiyor diyebiliriz. Sitede bu durumdan şöyle bahsediyor:

DataSet(Veri Kümeleri) hakkında günümüzden bir örnek vererek konunun anlaşılabilirliğini artıralım. Şu sıralar Mozilla'nın yürüttüğü Common Voice adında bir proje var. Bu projede amaçlanan şey makinelere gerçek insanların nasıl konuştuğunu öğretmek. Peki bu nasıl yapılacak? Bunun için devasa bir veri kümesine yani DataSet'e ihtiyacımız var. Bu veri kümesi farklı insan seslerini ve farklı kelimeleri kapsayacak. Bu devasa veri kümesini elde etmenin farklı yolları var ancak Mozilla bunu ucuza getirmek için bu proje kapsamında dünyadaki tüm insanlardan ses örneği alıyor. Aslında ucuza getirmenin yanı sıra bunu açık halde sunmak istiyor diyebiliriz. Sitede bu durumdan şöyle bahsediyor:

Ses doğaldır, insanidir. Bu yüzden makinelerimiz için kullanılabilir ses teknolojileri üretmekle ilgileniyoruz. Ama ses sistemleri yaratmak için geliştiricilerin çok büyük miktarlarda ses verisine ihtiyacı var. Büyük şirketlerin kullandığı verilerin çoğu insanların çoğunluğunun kullanımına açık değil. Biz bunun yenileşmeyi bastırdığını düşünüyoruz. Bu yüzden ses tanıma sistemlerini herkese açık ve erişilebilir hale getirmek için Common Voice projesini başlattık.

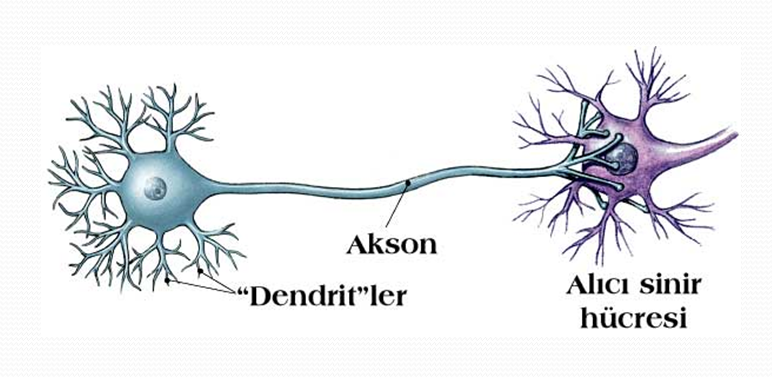

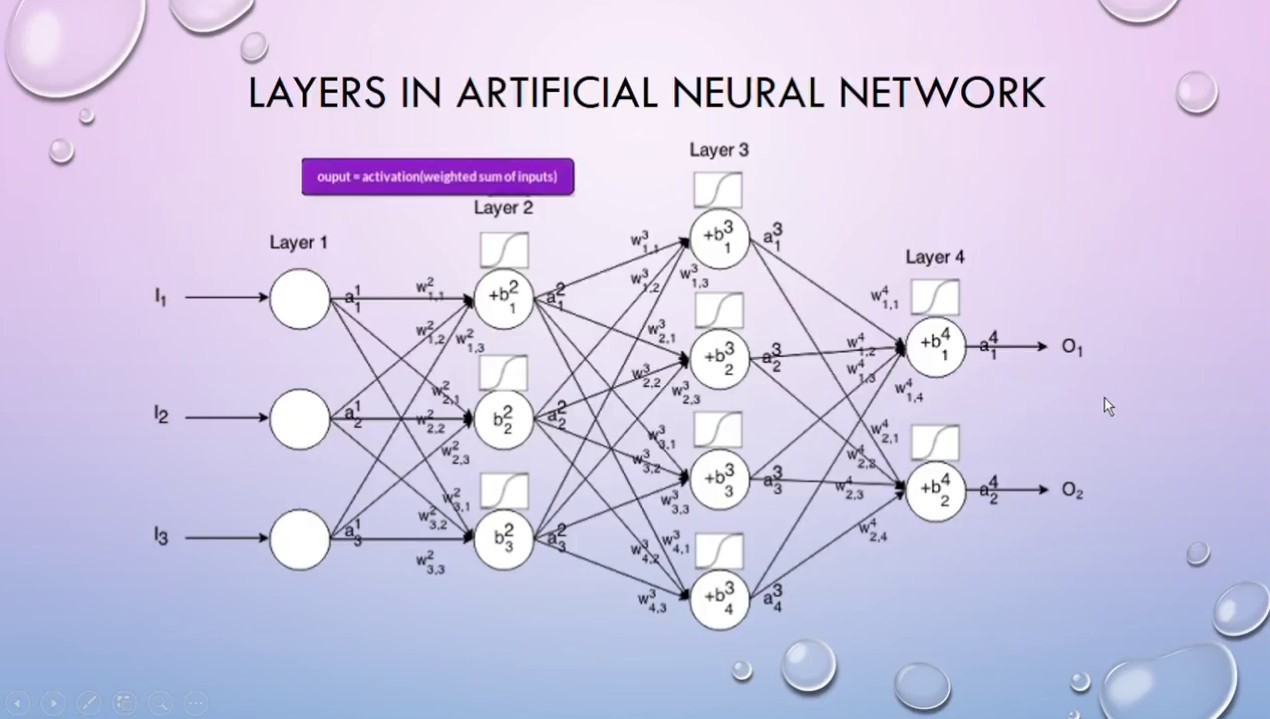

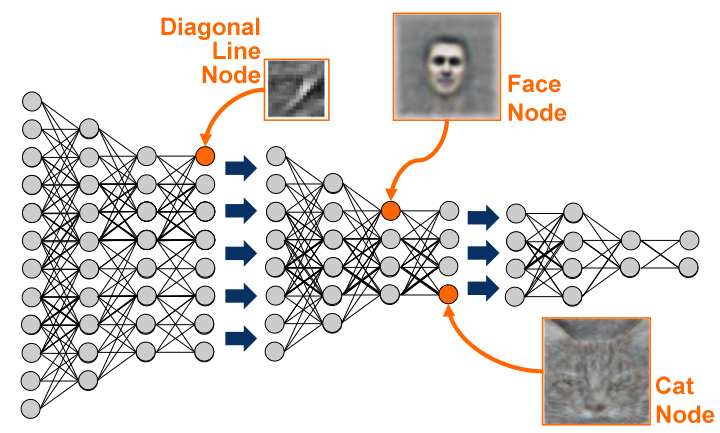

İsterseniz siz de siteye giderek sesinizi bağışlayabilir veya sesleri inceleyerek onaylayabilirsiniz. Ayrıca ülkelerin ses bağışlama sayılarına da bakabilirsiniz. Gelelim derin öğrenmeye, Derin öğrenme kavramı 2010'lu yıllarda ortaya çıkan bir kavram. Makine öğrenmesinin türlerinden biri olan derin öğrenme; konuşma tanıma, nesne tanıma ve dil işleme gibi alanlarda yapay sinir ağlarını* kullanan bir yapay zeka yöntemidir. Derin öğrenme insan beyninin işlevini taklit eden yapay sinir ağlarına dayanmaktadır. Hemen makine öğrenimi ve derin öğrenme arasındaki farkı bir örnek ile netleştirmeye çalışalım. Elimizde iki fotoğraf olsun. Bu iki fotoğrafın birinde kola fotoğrafı birinde fanta fotoğrafı olsun. Makine öğrenmesinde, bugüne kadar edinilmiş deneyimleri parametreler aracığıyla makineye tanıtmaya çalışırız. (Siyah ise koladır, sarı ise fantadır gibi.) Bunun gibi birçok parametreyi tanımlamamız gerekir. Derin öğrenme ise bu farkları kendi kendine öğrenebilir. Kola ve fanta fotoğraflarını sisteme gösteririz ve derin öğrenme algoritması kendi kurallarını oluşturur, farkları açığa çıkarabilmek için rengi ana ayırıcı özellik olduğunu fark eder. Makine öğrenimi için nesneyi diğer türlerden ayıran özelliklerini sisteme veririz. Derin öğrenmede ise verdiğimiz görseller ile ayırt edici özellikleri algoritmanın içinde kendisi bulur. Derin öğrenme Artificial Neural Networks(Yapay Sinir Ağları) üzerinden bir öğrenim sağlar. Yapay sinir ağları, insan beynini taklit ederek geliştirilmiş bir ağ yapısıdır. İnsanda olduğu gibi yapay sinir ağları vasıtasıyla makinelerin eğitilmesi, öğrenmesi ve karar vermesi amaçlanmaktadır. İnsanı ele alalım: İnsan beynindeki her nöron temelde bir gövde, bir akson ve pek çok dendritten oluşur. Nöronlar arasında kurulan iletişim her zaman devam eden bir bilgi alışverişini sağlar. Bu bağlantılar öğrenme, beslenme ve alışkanlıklar gibi birçok farklı etmen tarafından etkinleştiriliyor, devre dışı bırakılıyor veya değiştiriliyor. Yapay sinir ağları sayesinde öğrenim kazanan derin öğrenme de işte bu işleyişi taklit ediyor. Nasıl mı?  Örnek olarak, elimizde bir portakal fotoğrafı olsun. Portakal fotoğrafını yapboz şeklinde 20 parçaya ayıralım. Bu 20 parçayı 20 farklı insana verelim. Her insan elindeki parçadan bir çıkarımda bulunur. İşte bu parça yuvarlak, bu parça köşeli vs. Daha sonra bu 20 insan elindeki parçaları bir sonraki 20 insana verir ve bu insanlar da önceki 20 insanın bilgisi üzerine yeni bilgiler katar. En son bütün bilgiler bir insanda toplanır. Bu insan bütün bu bilgilere bakarak bunun %90 ihtimalle portakal olduğunu söyleyebilirim der. Yine son insan bu bilgilerin doğruluğunu ölçmek için geriye doğru gider ve hangi insanların yanlış bilgi verdiğini bulur. Bu geriye doğru tarama süreci, bundan sonraki öğrenimlerde o insanların verdikleri bilgilere daha az ağırlık verilmesi ve doğruluğun artması için önemlidir. İşte aslında bu insandaki öğrenmeyi taklit eden bir yapay sinir ağıdır. Yapay sinir ağları ve derin öğrenme kullanılarak insan beynindeki düşünceleri okuyup felçli bir insanın hareket etmesi sağlanabilir. Bu, öğrenmenin tıp alanında bir kullanımıdır ve gelişen bu sistem, ileride felç tedavisi için büyük bir umut ışığı olabilir. Bir örneğini sizler için buraya bırakıyoruz.

Örnek olarak, elimizde bir portakal fotoğrafı olsun. Portakal fotoğrafını yapboz şeklinde 20 parçaya ayıralım. Bu 20 parçayı 20 farklı insana verelim. Her insan elindeki parçadan bir çıkarımda bulunur. İşte bu parça yuvarlak, bu parça köşeli vs. Daha sonra bu 20 insan elindeki parçaları bir sonraki 20 insana verir ve bu insanlar da önceki 20 insanın bilgisi üzerine yeni bilgiler katar. En son bütün bilgiler bir insanda toplanır. Bu insan bütün bu bilgilere bakarak bunun %90 ihtimalle portakal olduğunu söyleyebilirim der. Yine son insan bu bilgilerin doğruluğunu ölçmek için geriye doğru gider ve hangi insanların yanlış bilgi verdiğini bulur. Bu geriye doğru tarama süreci, bundan sonraki öğrenimlerde o insanların verdikleri bilgilere daha az ağırlık verilmesi ve doğruluğun artması için önemlidir. İşte aslında bu insandaki öğrenmeyi taklit eden bir yapay sinir ağıdır. Yapay sinir ağları ve derin öğrenme kullanılarak insan beynindeki düşünceleri okuyup felçli bir insanın hareket etmesi sağlanabilir. Bu, öğrenmenin tıp alanında bir kullanımıdır ve gelişen bu sistem, ileride felç tedavisi için büyük bir umut ışığı olabilir. Bir örneğini sizler için buraya bırakıyoruz.

Peki bu öğrenme çeşitlerinde neler kullanılıyor?

Bulanık mantık kavramından başlayalım. İnsan ve makinenin birbirine en çok yaklaştığı noktalardan biri olarak kabul edilen bu yaklaşımda, insan tecrübesi ve insana ait çeşitli veri kümeleri, makineler tarafından kullanılabilecek şekilde onlara aktarılıyor. Bulanık mantık bilinen klasik mantık gibi (0,1) olmak üzere iki seviyeli değil. [0,1] aralığında çok seviyeli işlemleri ifade eder. Yani bulanık mantıkta kesin varsayımlar yerine yaklaşık düşünme varsayımları kullanılır. Birçok ifadeyi sınırlar içerisinde sınıflandırmak mümkün(iyi-kötü, evet-hayır) ancak bazı kavramları ise kesin sonuçlara ayırmamız mümkün değil. Bu kesin yargılar dışında kalan değerleri kullanabilmemiz ve makinelerin değerlendirmesi için bulanık mantık devreye giriyor. Makine öğrenmesi farklı türlerde yapılabiliyor. İlk olarak bakacağımız terim Supervised Learning(Gözetimli öğrenme). Elimizdeki verinin sınıfı belli ise yani elimizdeki verilerin hangi girdi değerinde hangi çıktıyı vereceğini biliyorsak buna gözetimli öğrenme diyoruz. Örnek olarak verdiğiniz fotoğrafların kedi mi köpek mi olduğuna karar veren bir sistem tasarlamak istiyoruz. İlk önce farklı kedi ve köpek fotoğrafları verip bunların kedi mi köpek mi olduğunu işaretlersek bu gözetimli öğrenme oluyor. Unsupervised Learning'de yani gözetimsiz öğrenmede ise eğitim verisi yoktur. (İşaretlenmiş veri yok.) Grupları algoritma içinde öğrenmeye çalışır. Bu tür algoritmalar verileri gruplayarak yeni veriyi en uygun gruba atamaya çalışır.

Reinforced Learning(Pekiştirmeli öğrenme), davranışçılık esasına dayalı bir öğrenme yöntemidir. Node(Düğüm)'ların bir alanda en yüksek ödül miktarına ulaşabilmesi için hangi eylemleri yapması gerektiğiyle ilgilenen bir makine öğrenmesi yaklaşımıdır. Bu öğrenmede sistem gözlem yapıyor ve bir seçim yapılmaya zorlanıyor. Bu seçim en yüksek ödül güdülü olduğu için ona göre bir seçim yapıyor. Her seçimin ardından yaptığı bu seçimler sistem için bir tecrübe oluyor. Daha sonraki adımlarda ise tecrübesine göre başarısı da artmış oluyor. Her adımda kendini geliştiren bu sistem büyük bir işlemci gücü istiyor. Çünkü gideceği adım sayısını sonsuz olarak nitelendirebiliriz. Bunu milyonlarca kez deneyimleyen ve en iyi sonuçları vermeye çalışan bir sistemden bahsediyoruz. Dota2, Starcraft ve satrançta dünyanın en iyi oynayan insanlarını yenen birçok farklı yapay zekadan bahsediyoruz. Pekiştirmeli öğrenmenin insanı yendiği bazı örnekler:

- Dota 2'yi pekiştirmeli öğrenme ile öğrenen bir AI'nin en iyi oyuncuları yenmesi.

- Google'ın yapay zekasının(DeepMind) Starcraft'da Dünya şampiyonlarını yenmesi.

Öğrenme yaklaşımlarında ne gibi yöntemler kullanılıyor?

Bu öğrenme yaklaşımları tahmin(prediction) ve sınıflandırma(classification) yapabilme yeteneğine sahiptir. Karar ağaçları ise gözetimli öğrenme algoritmalarından biridir. Temel fikri, giriş verisinin tekrar tekrar gruplara bölünmesine dayanır. Grubun bütün elemanları aynı sınıf etiketine sahip olana kadar bölünme devam eder.

Yapay zeka, makine öğrenmesi ve derin öğrenmeyi kapsayan bir terim. Aşağıdaki görsel ile bunu gösterelim.

Umuyoruz ki bu terimler arasındaki farkı anlatabilmişizdir. İsterseniz gelin bir de bu öğrenme dalları günümüzde nerelerde kullanıyor ona bakalım. Yapay zeka ve öğrenme dalları günümüzde genel olarak oyun sektöründe, reklamlarda(pazarlama), sosyal medyada, sağlıkta, arama motorlarında, robotlarda ve IoT'da* kullanılıyor. Gelecekte Web 3.0(Semantic Web*) ve Endüstri 4.0 ile öğrenim ve yapay zekanın daha çok kullanılacağı kesin. IoT ve Semantic Web kavramlarının açıklamasına ve örneklerine birazdan değineceğiz. Fakat önce, kullanılan alanlarda bu işleyiş nasıl oluyor ona bakalım.

Umuyoruz ki bu terimler arasındaki farkı anlatabilmişizdir. İsterseniz gelin bir de bu öğrenme dalları günümüzde nerelerde kullanıyor ona bakalım. Yapay zeka ve öğrenme dalları günümüzde genel olarak oyun sektöründe, reklamlarda(pazarlama), sosyal medyada, sağlıkta, arama motorlarında, robotlarda ve IoT'da* kullanılıyor. Gelecekte Web 3.0(Semantic Web*) ve Endüstri 4.0 ile öğrenim ve yapay zekanın daha çok kullanılacağı kesin. IoT ve Semantic Web kavramlarının açıklamasına ve örneklerine birazdan değineceğiz. Fakat önce, kullanılan alanlarda bu işleyiş nasıl oluyor ona bakalım.

Geleceğin Dünyası

Oyun alanında kullanılan öğrenim yapısına örnek olarak rekabetçi oyunlarda takımımıza ve karşımıza gelebilecek oyuncuların önceki oyun maçlarında gösterdiği performanslara ve o maçlardan ne kadar mutlu ayrıldığına göre bir yerleştirme yapar. Buradaki amacı bize en iyi oyun deneyimini sunmaktır. Bunu belli parametreler ile öğrenir ve geliştirmeye çalışır. Yine oyun sektöründen bir örnek verecek olursak Minecraft oyununda dünyanın siz ilerledikçe dizayn edilmesi aslında öğrenimle ortaya çıkan bir olay. Haritanın geri kalan bölümüne benzer bir şekilde belli bir algoritmayla haritayı devam ettirmesi bu öğrenim algoritmasına gösterilen bir davranış. Sağlıkta ise kanser hücrelerini yakalamak, genler üzerinden hastalık çıkartmak veya felçli hastaların yapay sinir ağları ile yeniden hareketini sağlayabilmek sağlık alanında yapılan çalışmalardan bazılarına örnek verilebilir. Robotlarda ise robotun hareketlerini ve düşünce yapısını gün geçtikçe geliştirmesi öğrenme ve tecrübe etmeye dayalı.  Makine öğreniminin en çok kullanıldığı alanlardan birisi de pazarlama yani reklamlar diyebiliriz. Önümüze gelen reklamların ilgi alanımıza göre gelmesi veya nerede geleceği buna bir örnek. İnternet sitelerine girdiğimizde karşımıza gelen reklamların bizim hangi bağlantıdan veya nereden geldiğimize göre düzenlenmesi de yine buna bir örnek verilebilir. Sosyal medyada ve ürün tavsiyelerinde de yine öğrenim algoritmaları kullanılıyor. Takip ettiğimiz hesaplara göre algoritmanın bize şunları da takip edebilirsiniz demesi bunun bir örneği. Uygulamaların, izlediğimiz dizilere veya dinlediğimiz şarkılara bakarak bize yeni dizi veya müzik önermesi de buna bir örnek. Bu öğrenimler aslında yeni bir alan oluşturuyor diyebiliriz o da Complex Network(Karmaşık Ağlar) Her bir karmaşık sistemin arkasında sistemin bileşenleri arasındaki etkileşimleri inceleyen ve kodlayan karmaşık bir ağ vardır. Örnek olarak Communication Network, kablolu internet bağlantıları veya kablosuz bağlantılar aracılığıyla birbiriyle iletişim halindeki cihazları tanımlar. Bu ağların ağ yapısı ve davranışları öğrenim yolu ile belirlenir ve ona göre algoritmalar oluşturur.

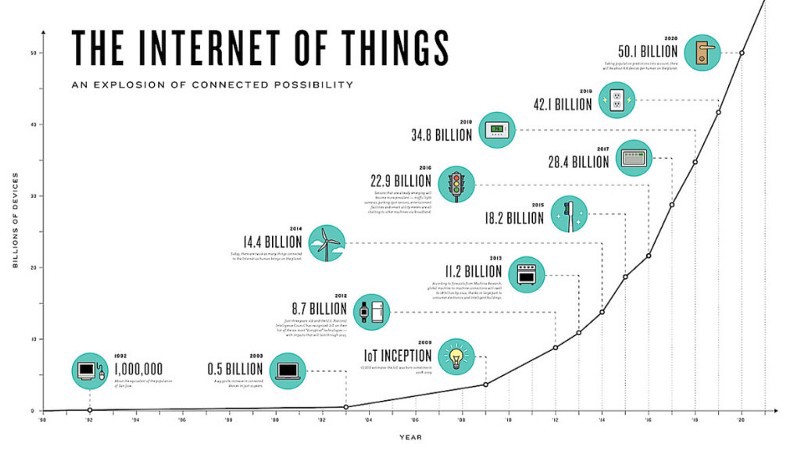

Makine öğreniminin en çok kullanıldığı alanlardan birisi de pazarlama yani reklamlar diyebiliriz. Önümüze gelen reklamların ilgi alanımıza göre gelmesi veya nerede geleceği buna bir örnek. İnternet sitelerine girdiğimizde karşımıza gelen reklamların bizim hangi bağlantıdan veya nereden geldiğimize göre düzenlenmesi de yine buna bir örnek verilebilir. Sosyal medyada ve ürün tavsiyelerinde de yine öğrenim algoritmaları kullanılıyor. Takip ettiğimiz hesaplara göre algoritmanın bize şunları da takip edebilirsiniz demesi bunun bir örneği. Uygulamaların, izlediğimiz dizilere veya dinlediğimiz şarkılara bakarak bize yeni dizi veya müzik önermesi de buna bir örnek. Bu öğrenimler aslında yeni bir alan oluşturuyor diyebiliriz o da Complex Network(Karmaşık Ağlar) Her bir karmaşık sistemin arkasında sistemin bileşenleri arasındaki etkileşimleri inceleyen ve kodlayan karmaşık bir ağ vardır. Örnek olarak Communication Network, kablolu internet bağlantıları veya kablosuz bağlantılar aracılığıyla birbiriyle iletişim halindeki cihazları tanımlar. Bu ağların ağ yapısı ve davranışları öğrenim yolu ile belirlenir ve ona göre algoritmalar oluşturur.  Arama motorlarında ise sorduğumuz ve arattığımız cümlenin karşımıza gelebilecek sonuçlarını en iyi duruma getirmek için kullanılır. Web 3.0 ile birlikte Semantic Web'e girmiş olacağız. Anlamsal ağ dediğimiz bu alan ise bize sorduğumuz soru karşılığında bir anlam ilişkisi kurarak zamansal olarak cevap döndürür. Örnek olarak Google arama motoruna "Hava kaç derece?" diye bir soru sorduğumuzda karşımıza konumumuzun olduğu hava derecesi gelir. Google, aslında bunu direkt soru olarak algılamıyor; hava ve derece kavramlarından yola çıkarak bize hava derecesini gösteriyor. "Hava kaç derece?" yerine "hava derece" yazıp arama yaparsak yine size aynı sonucu döndürecektir. Web 3.0 ile birlikte anlamsal ağ ve zaman kavramı tam anlamıyla işliyor olacak. Google'a "Vivaldi hangi telefonu kullandı?" diye bir soru sorduğumuzda Google, "Vivaldi zamanında telefon yoktu." diye bir cevap verebilecek. Şu an ise böyle bir durum söz konusu değil. IoT(Internet of Things) yani Nesnelerin İnterneti. Nesnelerin birbirleri ile etkileşim içinde olması durumudur. Cihazları ve ürünleri yani nesneleri internete bağlayarak komut iletmesini ve komut alabilmesini sağlıyoruz. Böyle nesneler hem birbirleriyle hem de bizlerle etkileşim sağlanmış oluyor. İnternete bağlı olan nesne bunu sensörler ve gateway sayesinde buluta iletiyor. Yani veri tabanına iletmiş oluyor. Sistemin diğer ucunda da diğer nesne var o da buluttan bilgiyi alıyor ve işliyor. Böylelikle nesneler birbirleri ile konuşabiliyor. Bu durumu biraz örneklendirelim.

Arama motorlarında ise sorduğumuz ve arattığımız cümlenin karşımıza gelebilecek sonuçlarını en iyi duruma getirmek için kullanılır. Web 3.0 ile birlikte Semantic Web'e girmiş olacağız. Anlamsal ağ dediğimiz bu alan ise bize sorduğumuz soru karşılığında bir anlam ilişkisi kurarak zamansal olarak cevap döndürür. Örnek olarak Google arama motoruna "Hava kaç derece?" diye bir soru sorduğumuzda karşımıza konumumuzun olduğu hava derecesi gelir. Google, aslında bunu direkt soru olarak algılamıyor; hava ve derece kavramlarından yola çıkarak bize hava derecesini gösteriyor. "Hava kaç derece?" yerine "hava derece" yazıp arama yaparsak yine size aynı sonucu döndürecektir. Web 3.0 ile birlikte anlamsal ağ ve zaman kavramı tam anlamıyla işliyor olacak. Google'a "Vivaldi hangi telefonu kullandı?" diye bir soru sorduğumuzda Google, "Vivaldi zamanında telefon yoktu." diye bir cevap verebilecek. Şu an ise böyle bir durum söz konusu değil. IoT(Internet of Things) yani Nesnelerin İnterneti. Nesnelerin birbirleri ile etkileşim içinde olması durumudur. Cihazları ve ürünleri yani nesneleri internete bağlayarak komut iletmesini ve komut alabilmesini sağlıyoruz. Böyle nesneler hem birbirleriyle hem de bizlerle etkileşim sağlanmış oluyor. İnternete bağlı olan nesne bunu sensörler ve gateway sayesinde buluta iletiyor. Yani veri tabanına iletmiş oluyor. Sistemin diğer ucunda da diğer nesne var o da buluttan bilgiyi alıyor ve işliyor. Böylelikle nesneler birbirleri ile konuşabiliyor. Bu durumu biraz örneklendirelim.  Mesela telefondan alarmımızı saat 7'ye kurduk. Alarm saat bilgisini buluttan alan kahve makinemiz kendini saat 6:55'e kurdu ve biz uyanmadan 5 dakika önce kahvemizi yapmaya başladı. Başka bir örnek ise buzdolabı üzerinden verilebilir. Buzdolabımızda yumurtamız azaldı diyelim. Buzdolabı bunu sensörler aracılığı ile algıladı ve bir komut oluşturdu. Bu buluta gitti ve oradan da alıcıya ulaştı. Burada alıcı bir market olabilir. Markete gelen bildirim doğrultusunda yumurta siparişimiz oluştu. Bir örnek daha verelim, trafikte belli bir araç kümesi gidiyor. En öndeki aracın önüne bir ağaç devrildi. Burada insanlar ani fren yapar ve bir risk doğabilir. Nesnelerin internetinde o kümedeki tüm araçlar birbiri ile iletişim halinde olacak. En öndeki araç fren yaptıktan sonra bunu bütün araç kümesine bildirecek. Saniyeler içinde iletilen bu bilgi sayesinde arkadaki araçlar ani fren yapmak yerine sistematik bir şekilde yavaşlayacak. Akıllı evlerin bazılarında olan bu sistemler genelde insan-nesne arasında oluyor.Henüz yaygınlaşmamış bu teknoloji Endüstri 4.0'ın hayatımıza girmeye başladığı dönemlerde daha da yaygınlaşacak. Peki ülkemiz bunun için ne kadar hazır? Bir video ile bunu daha da kavrayabiliriz.

Mesela telefondan alarmımızı saat 7'ye kurduk. Alarm saat bilgisini buluttan alan kahve makinemiz kendini saat 6:55'e kurdu ve biz uyanmadan 5 dakika önce kahvemizi yapmaya başladı. Başka bir örnek ise buzdolabı üzerinden verilebilir. Buzdolabımızda yumurtamız azaldı diyelim. Buzdolabı bunu sensörler aracılığı ile algıladı ve bir komut oluşturdu. Bu buluta gitti ve oradan da alıcıya ulaştı. Burada alıcı bir market olabilir. Markete gelen bildirim doğrultusunda yumurta siparişimiz oluştu. Bir örnek daha verelim, trafikte belli bir araç kümesi gidiyor. En öndeki aracın önüne bir ağaç devrildi. Burada insanlar ani fren yapar ve bir risk doğabilir. Nesnelerin internetinde o kümedeki tüm araçlar birbiri ile iletişim halinde olacak. En öndeki araç fren yaptıktan sonra bunu bütün araç kümesine bildirecek. Saniyeler içinde iletilen bu bilgi sayesinde arkadaki araçlar ani fren yapmak yerine sistematik bir şekilde yavaşlayacak. Akıllı evlerin bazılarında olan bu sistemler genelde insan-nesne arasında oluyor.Henüz yaygınlaşmamış bu teknoloji Endüstri 4.0'ın hayatımıza girmeye başladığı dönemlerde daha da yaygınlaşacak. Peki ülkemiz bunun için ne kadar hazır? Bir video ile bunu daha da kavrayabiliriz.

Yazının sonuna doğru gelirken günümüzden birkaç yapay zeka çalışması örneği verelim.

Nvidia, Mart ayında yeni yapay zekası GauGAN'ı tanıtmıştı. GauGAN, öğrenme ile eğitilmiş ve çok başarılı sonuçlar vermişti. Temel olarak GauGAN, basit çizimleri bir şahesere dönüştürebiliyor. İlgili haberimize buradan bakabilirsiniz.

Samsung'un yapay zekası ise çok ünlü portreleri hareketli görüntülere dönüştürebiliyor. Bu modelin öğrenme sürecinde yapay sinir ağları kullanılmış. Detaylara buradan bakabilirsiniz.

Google Translate'de aslında yapay zekaya bir örnektir. Metinlerin tercümesi yine veri setleri ve öğrenme ile mümkün.

Terimler ve Kısa Kısa Açıklamaları

Artificial Neural Networks: Yapay sinir ağlarıdır. İnsandaki sinir ağlarının taklit edilmiş halidir. Derin öğrenme bu yolla sağlanır. Computer Vision: Nesne tanıma ve görüntü işleme gibi alt alanları vardır. Makinenin öğrenmesi ile birlikte bu alanda birçok yeni yazılım geliştirilebilir. Data Science: Veri bilimi, yapılandırılmış ve yapılandırılmamış verilerden bilgi elde etmek için bilimsel yöntemleri, süreçleri, algoritmaları ve sistemleri kullanan çok disiplinli bir alandır. DataSet: Veri kümesidir. Öğrenme sırasında kullanılacak verilerdir. Data Mining: Büyük miktarda verinin içerisinden anlamlı sonuçlar çıkartabilmek amacıyla otomatik ya da yarı otomatik yöntemlerle işlenmesi ve anlamlı verilere ulaşılması diyebiliriz. Veri madenciliğinden en önemli disiplinlerin başında makine öğrenmesi geliyor. Ayrıca ortaya çıkan sonuçların analiz edilmesinde ise istatistik biliminden faydalanılıyor. IoT: Nesnelerin interneti. Nesnelerin çoğu internete bağlı olması ve aralarında sürekli bir iletişim olması durumu. TensorFlow: Makine öğrenmesi ve derin öğrenmede kullanılan açık kaynak kodlu bir Deep Learning(derin öğrenme) kütüphanesidir. Google'ın geliştirdiği ve Python programlama dilini kullanan TensorFlow, alanında en çok kullanılan kütüphanedir. Turing Testi: Yapay zekayı ölçen bir test. Yapay zeka bu testi geçebilirse insanla ayırt edilemez bir zeka olmuş oluyor. Weka: Bilgisayar bilimlerinin önemli konularından birisi olan makine öğrenmesi konusunda kullanılan paketlerden birisinin ismidir.

Son söz ve yazarın yorumu

Gelecek beni çok heyecanlandırıyor. Yapay zekanın çok üst noktalara ulaşıyor olması, verinin günümüzden bile çok değerli olacak olması, veri güvenliğinin hiç olmadığı kadar çok önemli olacak olması gelecekten birkaç kesit. Makine öğrenmesi ve derin öğrenme yine bu alanda karşımıza çıkıyor. Yapay sinir ağları gibi alanlarda da gün geçtikçe gelişmeler kaydediliyor. Önümüzdeki yıllarda artık çoğu nesnenin internete bağlı olacağı ve çoğu bilginin bulutta saklanacak olması veri güvenliğinin ne kadar önemli olacağını gösteriyor. İnsanların bile çiplerle bağlı olacağını düşünebiliriz. Artık her şey internet olacak ve her şeye bulut üzerinden erişilebilecek. [caption id="attachment_179490" align="aligncenter" width="1600"] Smart city and communication network concept. IoT(Internet of Things).[/caption] Peki bu durum için endişelenmeli miyiz yoksa heyecanlanmalı mıyız? Bana göre endişelenecek bir durum yok. Yapay zeka çok gelişiyor insanlığın sonu olacak gibi ifadeler bana göre çok doğru olmayan varsayımlar. Bu durumu Stanford Üniversitesinde Bilgisayar Bilimi profesörü olan Prof. Andrew Ng şöyle açıklıyor. "Bugün yapay zekânın şeytani bir süperzekâya dönüşmesinden endişe etmek, Mars'taki nüfus artışı sorunu konusunda endişe etmeye benziyor. Daha Mars'a iniş bile yapmadık!" O yüzden daha gidilecek çok yol var ve bu yol gerçekten çok heyecan verici. Çoğu yerde göreceğimiz hiçbir insana bağlı olmayan gelişmiş yapay zekalar ile fabrikalar 7/24 çalışacak ve bu yapay zekalar hataları kendi kendine çözebilecek. İnsan gücünü fabrikalardan çektiğimiz zaman ve sadece yapay zekaya bırakacağımız an hataları neredeyse sıfıra indirmiş olacağız. Peki bu işsizliğe neden olacak mı? Hayır olmayacak çünkü birçok yeni iş alanı doğacak deniliyor. Detaylı bilgi için yukarıda bıraktığım TEDx konuşmasını dikkatle izlemenizi öneririm. Devir gerçekten teknoloji devri, ülke olarak buna ne kadar hazırız, alt yapımız var mı bunları düşünmemiz gerekiyor. Bu yazımızda günümüzde yapay zekada neler oluyor, ne gibi teknolojiler var, gelecekte bizi neler bekliyor onlara değinmeye çalıştım. Umarım faydalı bir yazı olmuştur. Son bir linki de sizin için buraya bırakıyorum.

Smart city and communication network concept. IoT(Internet of Things).[/caption] Peki bu durum için endişelenmeli miyiz yoksa heyecanlanmalı mıyız? Bana göre endişelenecek bir durum yok. Yapay zeka çok gelişiyor insanlığın sonu olacak gibi ifadeler bana göre çok doğru olmayan varsayımlar. Bu durumu Stanford Üniversitesinde Bilgisayar Bilimi profesörü olan Prof. Andrew Ng şöyle açıklıyor. "Bugün yapay zekânın şeytani bir süperzekâya dönüşmesinden endişe etmek, Mars'taki nüfus artışı sorunu konusunda endişe etmeye benziyor. Daha Mars'a iniş bile yapmadık!" O yüzden daha gidilecek çok yol var ve bu yol gerçekten çok heyecan verici. Çoğu yerde göreceğimiz hiçbir insana bağlı olmayan gelişmiş yapay zekalar ile fabrikalar 7/24 çalışacak ve bu yapay zekalar hataları kendi kendine çözebilecek. İnsan gücünü fabrikalardan çektiğimiz zaman ve sadece yapay zekaya bırakacağımız an hataları neredeyse sıfıra indirmiş olacağız. Peki bu işsizliğe neden olacak mı? Hayır olmayacak çünkü birçok yeni iş alanı doğacak deniliyor. Detaylı bilgi için yukarıda bıraktığım TEDx konuşmasını dikkatle izlemenizi öneririm. Devir gerçekten teknoloji devri, ülke olarak buna ne kadar hazırız, alt yapımız var mı bunları düşünmemiz gerekiyor. Bu yazımızda günümüzde yapay zekada neler oluyor, ne gibi teknolojiler var, gelecekte bizi neler bekliyor onlara değinmeye çalıştım. Umarım faydalı bir yazı olmuştur. Son bir linki de sizin için buraya bırakıyorum.

Yorum Bırakın